De afgelopen jaren heb ik veel kritiek uitgeoefend op de digitale examens die afgenomen worden op basisberoeps- en kaderberoepsgerichte leerweg, bijvoorbeeld vanuit mijn column in Trouw en de digitale pagina’s van de Correspondent.

De afgelopen jaren heb ik veel kritiek uitgeoefend op de digitale examens die afgenomen worden op basisberoeps- en kaderberoepsgerichte leerweg, bijvoorbeeld vanuit mijn column in Trouw en de digitale pagina’s van de Correspondent.

Wat waren indertijd mijn voornaamste bezwaren?

Geen tweede correctie. Alleen de eigen docent kijkt het werk na; alleen vreemde ‘afwijkingen’ worden bij de najaarscorrectie door een commissie nagelopen. Leerlingen kunnen hierdoor bevoordeeld of benadeeld worden.

Geen openbaarheid. De toetsen worden niet openbaar gemaakt. Aangezien er al veel discussie is over de toetsen die wel gewoon openbaar gemaakt worden (zoals dit jaar Frans, economie en Nederlands), lijkt me dat kwalijk. Een vorm van democratische controle is nodig om de examenmakers scherp te houden.

Beperkte oefenmogelijkheid. Als leerlingen een papieren examen moeten maken dan kunnen ze het internet leegtrekken aan oefenexamens, en het lijkt bovendien op wat leerlingen in de les doen. Maar een digitaal examen vereist wat knoppenkennis: hoe teken je punten op het beeldscherm en hoe trek je een kromme lijn? Dat vereist wat oefening, maar dat was in de beschermde softwareomgeving moeilijk te organiseren.

Vanwege de flexibele inplanning van het examen, zijn er diverse versies van een examen per jaar. Zij maken dus verschillende versies, soms ook binnen een klas waarbij ze qua inhoud erg kunnen verschillen. Dat wordt later wel met een N-term gecorrigeerd, maar de vraag is of dat zo maar kan, en of dat wel eerlijk is.

Om de normering te bepalen wordt er niet gebruik gemaakt van de reguliere pre-test/post-test methode – ik kom er dadelijk op terug –, maar van ankervragen. Dat zijn vragen die in examens van latere jaren weer gebruikt kunnen worden om zo het niveau constant te houden. Het is gemakkelijk voor leraren om screenshots te maken van alle opgaven, waardoor ze later met nieuwe examenkandidaten gericht kunnen oefenen, in de hoop dat een aantal van deze vragen terugkomt.

Mijn kritiek leidde tot Kamervragen door Tanja Jadnanansing, en die werden nogal snibbig beantwoord door OCW. Het is ze vergeven, want achter de schermen gebeurde er namelijk een heleboel.

Een aantal punten is inmiddels gecorrigeerd.

Experiment met tweede correctie: Bij de oude software waar de examens op draaiden was tweede correctie niet mogelijk. In de nieuwe software kan dit wel, en hier wordt nu een experiment mee gedraaid.

Gedeeltelijke openbaarheid: Het College voor Toetsen en Examens heeft de Kamer een aantal opties aangeboden voor openbaarheid. De staatssecretaris koos uiteindelijk de meest voor de hand liggende variant, waarbij 2/3 van het examen na de herkansingen wordt vrijgegeven, de ankeropgaven blijven geheim tot ze nogmaals gebruikt zijn, dan worden die ook openbaar.

Voldoende oefenmogelijkheden: Leerlingen kunnen binnen de nieuwe softwareomgeving online oefenen, dat kunnen ze nu dus ook thuis. Voor wiskunde zijn er bijvoorbeeld twee examens en een knoppencursus te vinden op oefenen.facet.onl.

Laten we hier eerst even bij stil staan.

Ik vind het goed om te zien dat het CvTE de kritiek ter harte neemt, en belangrijke verbeterstappen heeft ondernomen. Bovenstaande verbeteringen maken het hele ‘pakket’ van digitale examinering natuurlijk al veel acceptabeler.

We komen zo ook dichtbij een punt dat ik digitale examens wellicht begin te prefereren boven papieren examens. Maar er rest nog steeds een fundamentele kwestie, die nog niet is opgelost. Daar wil ik graag in een vervolgblog de aandacht op vestigen. In deze blog wil ik daarvoor een opmaat geven.

Eerst een stukje theorie.

We willen graag dat een havo-diploma dat afgegeven is in 2016 even veel waard is als een diploma dat is afgegeven in 2017. Daarom zou een denkbeeldige leerling die een 6,5 haalt voor Nederlands in 2016, met hetzelfde niveau ook een 6,5 moeten halen in 2017.

Iedereen snapt dat dat ingewikkeld is. Je kan niet ieder jaar dezelfde teksten voorleggen, en je kan ook niet telkens dezelfde vragen stellen. Soms spreken onderwerpen kandidaten wel aan, soms zijn de woorden wel of niet begrijpelijker. De opbouw van een examen kan ook voor een niveauverschil zorgen tussen jaren, evenals de lengte van het examen. Er zijn veel factoren die op het ‘niveau’ van een examen inwerken en dat moet uiteraard gecorrigeerd worden.

Vroeger konden examens alleen opgewaardeerd worden. Als een examen te moeilijk werd bevonden, dan kon het CvTE bonuspunten toekennen.

Inmiddels zijn ze overgestapt naar de N-term. Daarmee kunnen er ook punten afgehaald worden, als een examen te makkelijk was.

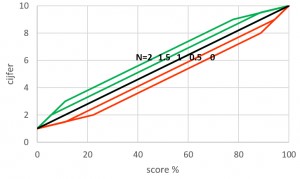

Bij een N-term van 1 (genoteerd als N=1) hebben leerlingen de helft van de punten nodig om een 5,5 te halen. De strengste norm is N=0. Dan hebben leerlingen iets meer dan 60% van de punten nodig voor een 5,5. Hoe hoger de N-term hoe minder punten leerlingen nodig hebben voor een 5,5. Hoger dan N=2 is heel ongebruikelijk.

Zie ook de grafiek hieronder.

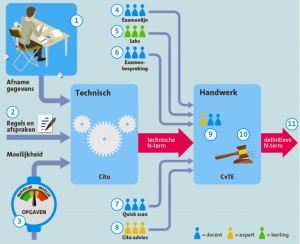

Maar hoe wordt die N-term vastgesteld? Dat heeft natuurlijk iets te maken met de moeilijkheid van een examen. Sommige mensen, vooral leerlingen, denken dat klagen bij het LAKS helpt om de normering te beïnvloeden, maar dat ligt iets ingewikkelder.

Het CvTE wil leerlingen niet helpen, of kapotmaken, die willen gewoon – zoals ik al zei – elk jaar een examen van eenzelfde niveau. Ze kijken natuurlijk met een schuin oog naar alle klachten, maar uiteindelijk zien ze in de statistieken die docenten aanleveren via de WOLF-rapportage hoe de leerlingen het gedaan hebben. Dat interpreteren doen ze overigens niet zelf maar dat doet Stichting Cito. Deze technische bepaling via de statistiek is de echte basis van de N-term. Op basis van allerlei signalen kan de vaststellingcommissie hier wel weer van afwijken.

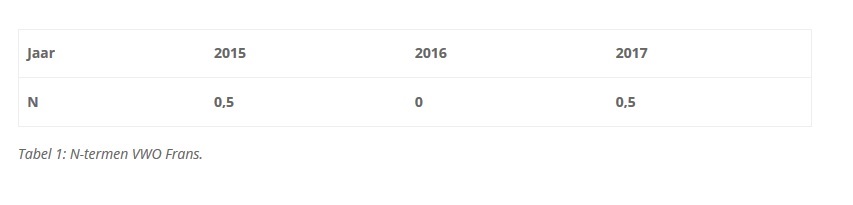

Zo heeft het CvTE op basis van de klachten dit jaar de N-term voor de vwo-examens Nederlands en Frans iets opgehoogd. Zo werd de N-term van Frans verhoogd naar een 0,5. Vermoedelijk was de technische vaststelling voor dit vak dus iets lager.

De N-term heeft dus maar één functie: het gelijk trekken van het niveau over de jaren heen. Wat we er niet uit kunnen aflezen – en dit is een veel gebezigd misverstand – is of een examen goed was of niet. Daar is weer een andere methodiek voor, waar ik misschien later op terug kom. Het is dus niet zo dat N=1 de norm is. Maar door in de loop der jaren alle N-termen naast elkaar te zetten is er wel een beeld te vormen over hoe een examen zich qua moeilijkheidsgraad verhoudt tot eerdere of andere jaren – volgens Cito en CvTE dan.

Bij het examen Frans kunnen we zien dat het examen van dit jaar als moeilijker werd beschouwd dan dat van vorig jaar, en even moeilijk als dat in 2015.

Maar hoe wordt dit nu technisch bepaald?

Dat is een statistisch complex verhaal. Het niveau van de leerlingen kan van jaar tot jaar verschillen, terwijl ook de moeilijkheid van de examens van jaar tot jaar kan verschillen. Als dat niet zo was, was equivaleren niet nodig (zie tabel hieronder). Als de leerlingpopulatie verschilt, maar het examenniveau niet, dan maken ze het uiteraard slechter. Equivalering is dan onwenselijk.

Hoewel het aannemelijk is dat er verschillen bestaan tussen leerlingpopulaties per niveau per jaar heeft het Cito voor het CvTE becijferd dat het verschil – over het land – genomen marginaal is. Dat verschilt nooit meer dan -0,1 of 0,1 (in termen van de B-term).

Bij relatief normeren wordt er voor de bepaling van de N-term gebruik gemaakt van een referentie-examen: een examen dat door docenten, leerlingen en examenmakers als afgewogen qua inhoud, lengte en moeilijkheidsgraad is bevonden. Wat de leerlingen landelijk haalden voor zo’n examen wordt gebruikt om de N-term technisch te bepalen. Er wordt simpelweg geschoven met de term tot het resultaat van het nieuwe examen gemiddeld even goed uitvalt. Dat noemen we relatief normeren.

Maar hoewel het aannemelijk is dat leerlingpopulaties van jaar tot jaar niet verschillen, hoeft dat natuurlijk niet het geval zijn. Voor een aantal examens wordt er daarom gebruik gemaakt van de pretest/posttest-methode. Ook hier is het referentie-examen van belang. In de pre-test maken examenkandidaten, in de periode voor het examen, een test waarin zowel opdrachten van dit referentie-examen als van het nieuwe examen zitten. Zo kan het niveau van het nieuwe examen vergeleken worden met dat van het referentie-examen. Om dit allemaal statistisch te versterken maakt het CvTE ook gebruik van een post-test. Dit kent dezelfde opzet, maar dan kort na het examen.

Deze laatste methode kent veel nadelen. Ze moeten deze testen door minstens 200 leerlingen gemaakt zijn, die ook nog eens geen enkele weet mogen hebben van het referentie-examen. En dat is lastig aangezien dit referentie-examen een eerder examen is dat gewoon online te vinden is. Moeilijk te organiseren dus, en daarom gebeurt het ook niet bij alle examens.

Daarom – en ik begrijp dat ik een hele omweg heb gemaakt – daarom lijkt het CvTE zijn hoop zo te hebben gevestigd op de digitale examens, want daarmee kan het een veel werkbaardere equivaleringsmethode toepassen, namelijk de anchor in package.

Het principe van anchor in package is eenvoudig. In een digitaal examen zitten een aantal opdrachten die ook in eerdere examens zaten. Dat zijn de ankeropgaven. Door te kijken naar hoe die gemaakt zijn ten opzichte van het vorige jaar kan gekeken worden of de leerlingpopulatie beter of slechter is, en daarmee kan dan ook worden gekeken of de overige opgaven moeilijker of niet moeilijker waren. Het voordeel is dus dat er niet aparte tests afgenomen hoeven te worden, de equivalering zit al in het systeem ingebakken.

Maar het is in deze methodiek dus wel nodig dat de ankeropgaven geheim blijven. Op verzoek van de Tweede Kamer en worden deze ankervragen na een tijdje wel vrijgegeven. Dat is kostbaar, want het ontwikkelen van examenvragen is duur, maar aan de andere kant zijn ankeropgaven, net als referentie-examens beperkt houdbaar bijvoorbeeld omdat de context – ‘het verhaaltje’ – veroudert.

Het CvTE probeert dus op verschillende manieren het niveau van diploma’s gelijk te houden. Een diploma dat in 2017 is afgegeven is net zoveel waard als een diploma uit 2016. Daarvoor maakt het CvTE gebruik van diverse statistische methodes. Die traditionele methodes zijn niet zonder problemen.

Bij relatieve normering wordt ervanuit gegaan dat leerlingpopulaties niet verschillen, maar stel nu eens dat het zo wel is. Wanneer je toevallig in een goede lichting zit, moet je dan een veel betere prestatie leveren dan wanneer je in een zwakke lichting zit. Niet helemaal eerlijk, en dus niet helemaal uitgesloten.

Bij absoluut normeren wordt pretest/posttest-methode gebruikt, maar daarvan is eigenlijk onduidelijk wat de betrouwbaarheid hiervan is.

De beste optie voor absoluut normeren, anchor in package, kan alleen in een digitale omgeving en vereist geheimhouding van opdrachten, wat politiek gevoelig ligt.

Net als zoveel andere dingen in het leven is er geen ideale oplossing.

Deze blog is een start van een serie over de digitale examens. Lees binnenkort op deze website deel 2.

Deze blog werd op 22 juni 2017 hier gepubliceerd.

En blijf op de hoogte van onderwijsnieuws en de nieuwste wetenschappelijke ontwikkelingen!

Inschrijven